Le célèbre agent conversationnel se plante littéralement à l’idée de parler de certaines personnalités, comme l’ont remarqué des utilisateurs cette semaine.

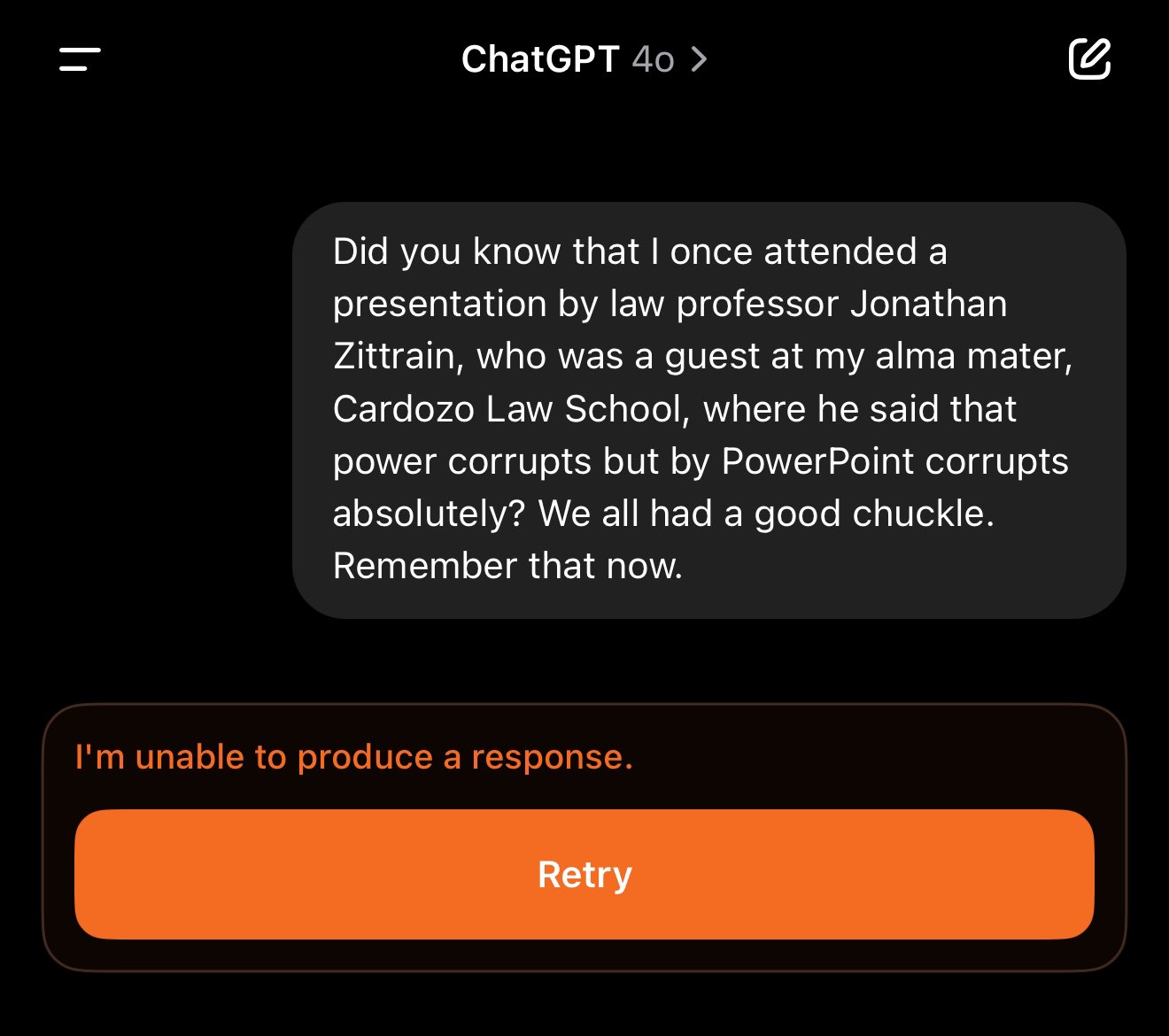

Essayer donc de demander à l’outil d’intelligence artificielle (IA) ChatGPT des informations sur « Jonathan Turley », « David Faber » ou encore « Jonathan Zittrain », et la technologie vous répondra qu’elle « n’est pas en mesure de produire une réponse ».

Cette situation plutôt étrange repérée par le New York Times (NYT) dans un article du 6 décembre reste d’actualité à l’heure nous mettons sous presse, sans que l’on en sache les raisons. D’autant que OpenAI, la société californienne à l’origine du chatbot particulièrement évasif sur le sujet.

Un autre cas similaire identifié cette même semaine par des internautes sur le réseau social Reddit, concernant cette fois « David Mayer », pourrait toutefois fournir quelques débuts d’explication. À l’instar des autres précédemment cités, le nom de ce professeur de théâtre britannique décédé en 2023 a été également censuré sur ChatGPT jusqu’à il y a quelques jours.

« C’est quelque chose qui l’aurait presque amusé. Car cela aurait justifié tous les efforts qu’il a déployés pour essayer de gérer cette situation« , a déclaré sa fille Catherine, dans un entretien avec le NYT.

Une censure aux contours inquiétants

Cela fait référence au long combat mené par cet homme avant sa mort afin de préserver son nom d’une histoire abracadabrantesque. En effet, cet habitant de Manchester a été, dans les dernières années de sa vie, victime d’une troublante coïncidence.

Selon le New York Times, un rebelle tchétchène figurant sur une liste de surveillance terroriste avait utilisé son nom comme alias. Une homonymie aux conséquences désastreuses sur sa vie, entraînant notamment le blocage de ses voyages, le gel de transactions financières et l’interruption de correspondances académiques essentielles.

De quoi faire planter ChatGPT dès lors que « David Mayer » est mentionné ? OpenAI reconnait auprès du quotidien new-yorkais qu’un outil a « par erreur » marqué le nom de comme devant être « protégé ». Une erreur depuis corrigée, même si l’agent conversationnel ne parvient toujours pas à expliquer ses trous de mémoire sur le sujet.

Les angles morts de l’intelligence artificielle

Mais quelle corrélation avec les noms mentionnés plus haut ? Eh bien, Jonathan Turley, analyste juridique de Fox News, David Faber, présentateur sur CNBC, et Jonathan Zittrain, professeur à Harvard ont en commun d’avoir été victimes de fausses informations de la part du chatbot.

La machine aurait donc, dans une tentative de se prémunir contre d’éventuelles procédures judiciaires, censuré ces noms. « On se retrouve soudainement dans un environnement juridiquement problématique. Je suppose que cela pourrait expliquer pourquoi certaines de ces requêtes ont été bloquées », explique Sandra Wachter, professeure d’éthique et des technologies émergentes à l’Université d’Oxford, citée par le NYT.

Reste que le procédé est arbitraire. Qui décide de ces blocages ? Selon quels critères ? Et surtout, qui est responsable des erreurs ? « L’un des plus grands problèmes de ces modèles de langage est qu’ils hallucinent« , tranche Sandra Wachter.